Az LLM-ek reduktív leírása az, hogy „egyszerűen megjósolják a sorozat következő szavát”. Ez igaz, de figyelmen kívül hagyja azt a tényt, hogy ez az egyszerű folyamat azt jelentheti, hogy az olyan eszközök, mint a ChatGPT, kiemelkedően jó minőségű szöveget állítanak elő. Ugyanilyen könnyű azt mondani, hogy „a modell egyszerűen matematikát csinál”, ami szintén igaz, de nem túl hasznos abban, hogy megértsük a modell működését vagy értékeljük erejét.

A fent leírt betanítási folyamat eredménye egy neurális hálózat, amely több százmilliárdnyi kapcsolattal rendelkezik a több millió neuron között, amelyek mindegyikét maga a modell határozza meg. A legnagyobb modellek nagy mennyiségű adatot képviselnek, talán több száz gigabájtot csak az összes súly tárolására.

A súlyok és a neuronok mindegyike egy matematikai képlet, amelyet minden egyes szóhoz (vagy bizonyos esetekben a szó egy részéhez) kell kiszámítani, amelyet a modellnek megadnak a beviteléhez, és minden egyes szóhoz (vagy részhez) szó), amelyet kimeneteként generál.

Ez egy technikai részlet, de ezeket a szórészeket „tokennek” nevezik, gyakran így árazzák ezeknek a modelleknek a használatát, amikor szolgáltatásként nyújtják őket – erről később.

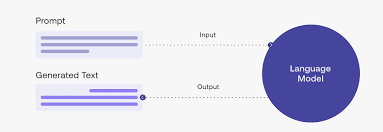

A modellek egyikével interakcióba lépő felhasználó szöveg formájában bevitelt biztosít. Például megadhatjuk a következő promptot a ChatGPT számára:

Hello ChatGPT! Kérlek, foglald össze nekem a magyar történelem 100 szavas leírását. Tartalmazzon évszámokat és eseményeket egyaránt.

A ChatGPT mögött álló modellek ezután tokenekre bontják ezt a promptot. Egy token átlagosan ⅘ egy szóból áll, így a fenti prompt és a benne lévő 23 szó körülbelül 30 tokent eredményezhet. A GPT-3 modell, amelyen a gpt-3.5-turbo modell alapul, 175 milliárd súllyal rendelkezik, ami azt jelenti, hogy a 30 token bemeneti szöveg 30 x 175 milliárd = 5,25 billió számítást eredményez. A ChatGPT-ben is elérhető GPT-4 modellnek ismeretlen számú súlya van.

Ezután a modell egy olyan választ generál, amely jól hangzik a képzés során felhasznált hatalmas szövegmennyiség alapján. Fontos, hogy nem keres semmit a lekérdezéssel kapcsolatban. Nincs olyan memóriája, amelyben kereshetne „magyar történelem”, „évszám”, „esemény” vagy bármely más releváns kifejezésre. Ehelyett hozzálát a kimeneti szöveg minden egyes tokenjének generálásához, újra elvégzi a 175 milliárd számítást, létrehozva egy olyan tokent, amely a legnagyobb valószínűséggel hangzik jól.